LLM大語言模型數(shù)據(jù)處理-Wikipedia(web text數(shù)據(jù))

LLM數(shù)據(jù)處理算法提供了對(duì)數(shù)據(jù)樣本進(jìn)行編輯和轉(zhuǎn)換、過濾低質(zhì)量樣本、識(shí)別和刪除重復(fù)樣本等功能。您可以根據(jù)實(shí)際需求組合不同的算法,從而過濾出合適的數(shù)據(jù)并生成符合要求的文本,方便為后續(xù)的LLM訓(xùn)練提供優(yōu)質(zhì)的數(shù)據(jù)。本文以開源RedPajama Wikipedia中的少量數(shù)據(jù)為例,為您介紹如何使用PAI提供的大模型數(shù)據(jù)處理組件,對(duì)Wikipedia數(shù)據(jù)進(jìn)行數(shù)據(jù)清洗和處理。

數(shù)據(jù)集說明

本文Designer中“LLM大語言模型數(shù)據(jù)處理-Wikipedia (web text數(shù)據(jù))”預(yù)置模板用的數(shù)據(jù)集為開源項(xiàng)目RedPajama的原始數(shù)據(jù)中抽取的5000個(gè)樣本數(shù)據(jù)。

創(chuàng)建并運(yùn)行工作流

進(jìn)入Designer頁面。

登錄PAI控制臺(tái)。

在頂部左上角根據(jù)實(shí)際情況選擇地域。

在左側(cè)導(dǎo)航欄選擇工作空間列表,單擊指定工作空間名稱,進(jìn)入對(duì)應(yīng)工作空間。

在左側(cè)導(dǎo)航欄選擇模型開發(fā)與訓(xùn)練 > 可視化建模(Designer),進(jìn)入Designer頁面。

創(chuàng)建工作流。

在預(yù)置模板頁簽下,選擇業(yè)務(wù)領(lǐng)域 > LLM 大語言模型,單擊LLM大語言模型數(shù)據(jù)處理-Wikipedia (web text數(shù)據(jù))模板卡片上的創(chuàng)建。

配置工作流參數(shù)(或保持默認(rèn)),單擊確定。

在工作流列表,選擇已創(chuàng)建的工作流,單擊進(jìn)入工作流。

工作流說明:

工作流中關(guān)鍵算法組件說明:

LLM-敏感信息打碼(MaxCompute)-1

將“text”字段中的敏感信息打碼。例如:

將郵箱地址字符替換成

[EMAIL]。將手機(jī)電話號(hào)碼替換成

[TELEPHONE]或[MOBILEPHONE]。將身份證號(hào)碼替換成

IDNUM。

LLM-特殊內(nèi)容移除(MaxCompute)-1

將“text”字段中的URL鏈接刪除。

LLM-文本標(biāo)準(zhǔn)化(MaxCompute)-1

將“text”字段中的文本進(jìn)行Unicode標(biāo)準(zhǔn)化處理;將繁體轉(zhuǎn)簡(jiǎn)體。

LLM-計(jì)數(shù)過濾(MaxCompute)-1

將“text”字段中不符合數(shù)字和字母字符個(gè)數(shù)或占比的樣本去除。wiki數(shù)據(jù)集中大部分字符都由字母和數(shù)字組成,通過該組件可以去除部分臟數(shù)據(jù)。

LLM-長(zhǎng)度過濾(MaxCompute)-1

根據(jù)“text”字段的平均長(zhǎng)度進(jìn)行樣本過濾。平均長(zhǎng)度基于換行符

\n分割樣本。LLM-N-Gram重復(fù)比率過濾(MaxCompute)-1

根據(jù)“text”字段的字符級(jí)N-Gram重復(fù)比率進(jìn)行樣本過濾,即將文本里的內(nèi)容按照字符進(jìn)行大小為N的滑動(dòng)窗口操作,形成了長(zhǎng)度為N的片段序列。每一個(gè)片段稱為gram,對(duì)所有gram的出現(xiàn)次數(shù)進(jìn)行統(tǒng)計(jì)。最后統(tǒng)計(jì)

頻次大于1的gram的頻次總和 / 所有gram的頻次總和兩者比率作為重復(fù)比率進(jìn)行樣本過濾。LLM-敏感詞過濾(MaxCompute)-1

使用系統(tǒng)預(yù)置敏感詞文件過濾“text”字段中包含敏感詞的樣本。

LLM-語種識(shí)別和過濾(MaxCompute)-1

計(jì)算“text”字段文本的置信度,根據(jù)設(shè)置的置信度閾值過濾樣本。

LLM-長(zhǎng)度過濾(MaxCompute)-2

根據(jù)“text”字段的最大行長(zhǎng)度進(jìn)行樣本過濾。最大行長(zhǎng)度基于換行符

\n分割樣本。LLM-困惑度過濾(MaxCompute)-1

計(jì)算“text”字段文本的困惑度,根據(jù)設(shè)置的困惑度閾值過濾樣本。

LLM-特殊字符占比過濾(MaxCompute)-1

將“text”字段中不符合特殊字符占比的樣本去除。

LLM-長(zhǎng)度過濾(MaxCompute)-3

根據(jù)“text”字段的長(zhǎng)度進(jìn)行樣本過濾。

LLM-分詞(MaxCompute)-1

將“text”字段的文本進(jìn)行分詞處理,并將結(jié)果保存至新列。

LLM-長(zhǎng)度過濾(MaxCompute)-4

根據(jù)分隔符

" "(空格)將“text”字段樣本切分成單詞列表,根據(jù)切分后的列表長(zhǎng)度過濾樣本,即根據(jù)單詞個(gè)數(shù)過濾樣本。LLM-N-Gram重復(fù)比率過濾(MaxCompute)-2

根據(jù)“text”字段的詞語級(jí)N-Gram重復(fù)比率(會(huì)先將所有單詞轉(zhuǎn)成小寫格式再計(jì)算重復(fù)度)進(jìn)行樣本過濾,即將文本里的內(nèi)容按照詞語進(jìn)行大小為N的滑動(dòng)窗口操作,形成了長(zhǎng)度為N的片段序列。每一個(gè)片段稱為gram,對(duì)所有gram的出現(xiàn)次數(shù)進(jìn)行統(tǒng)計(jì)。最后統(tǒng)計(jì)

頻次大于1的gram的頻次總和 / 所有gram的頻次總和兩者比率作為重復(fù)比率進(jìn)行樣本過濾。LLM-文章相似度去重(MaxCompute)-1

根據(jù)設(shè)置的Jaccard相似度和Levenshtein距離閾值去除相似的樣本。

運(yùn)行工作流。

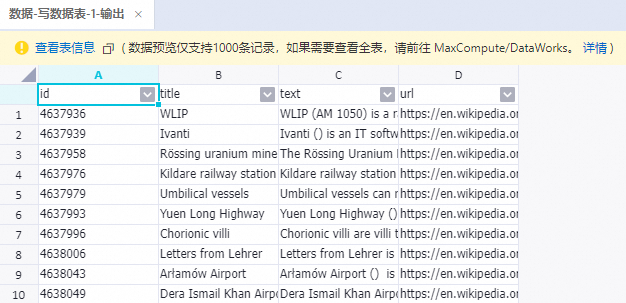

運(yùn)行結(jié)束后,右鍵單擊寫數(shù)據(jù)表-1組件,選擇查看數(shù)據(jù) > 輸出,查看經(jīng)過上述所有組件處理后的樣本。

相關(guān)參考

LLM算法組件詳細(xì)說明,請(qǐng)參見LLM數(shù)據(jù)處理(MaxCompute)。

在完成數(shù)據(jù)處理后,您可以使用PAI平臺(tái)提供的一系列大模型組件(包括數(shù)據(jù)處理組件、訓(xùn)練組件以及推理組件),來實(shí)現(xiàn)大模型從開發(fā)到使用的端到端流程。詳情請(qǐng)參見LLM大語言模型端到端鏈路:數(shù)據(jù)處理+模型訓(xùn)練+模型推理。