本文為您介紹在PAI-Model Gallery中部署或微調訓練模型時常見的問題及解決方式。

訓練任務失敗后,如何排查失敗原因?

訓練任務失敗有很多可能的原因,比如用戶準備的數據集格式不符合要求等。您可以嘗試通過以下方式排查失敗原因:

查看任務診斷:在PAI-Model Gallery > 任務管理 > 訓練任務中單擊指定任務,在任務詳情頁簽下鼠標懸停于失敗,系統會顯示錯誤原因及解決辦法。

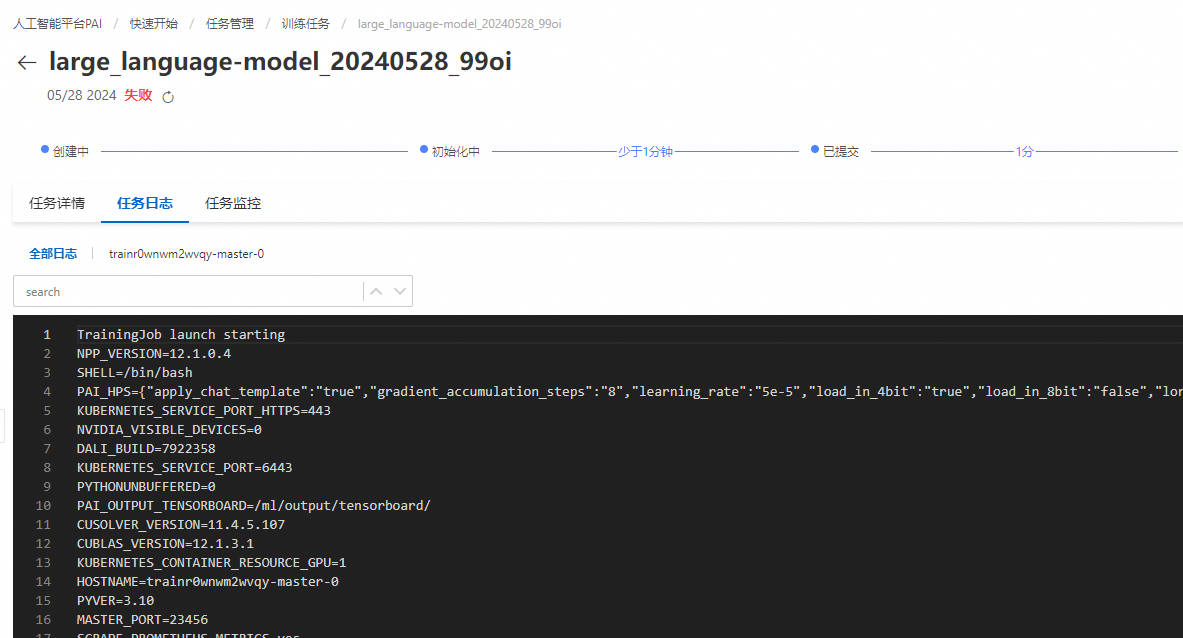

查看任務日志:在任務管理 > 訓練任務中單擊指定任務,在任務日志頁簽下查看錯誤信息:

具體錯誤信息對應解決方法如下:

錯誤類型

錯誤信息

解決辦法

輸入/輸出錯誤相關

ValueError: output channel ${your OSS uri} must be directory

檢查訓練設置的輸出路徑是否為文件夾,系統要求輸出路徑必須是一個文件夾。

ValueError:train must be a file

檢查選擇的輸入路徑是否為文件,系統要求輸入路徑必須是文件。

FileNotFoundError

檢查選擇的輸入路徑是否存在符合要求的文件。

JSONDecodeError

檢查輸入的JSON文件格式是否正確。

ValueError: Input data must be a json file or a jsonl file!

檢查輸入文件是否符合要求,要求為JSON或JSONL文件。

KeyError:${some key name}

多見于JSON格式訓練集文件,根據模型說明頁面檢查訓練集文件各個key-value值是否符合模型要求。

ValueError: Unrecognized model in /ml/input/data/model/.

PyTorch無法識別提供的模型文件。

UnicodeDecoderError

檢查輸入文件的編碼格式是否正確。

Input/output error

檢查輸入路徑是否具有讀權限,輸出路徑是否具有讀寫權限

NotADirectoryError: [Errno 20] Not a directory:

檢查輸入/輸出路徑是否為文件夾。

超參數配置相關

ERROR:torch.distributed.elastic.multiprocessing.api:failed (exitcode: -9) local_rank: 0 (pid: 51) of binary: /usr/bin/python(且沒有相關subprocess的日志)

當前機型內存不足,加載模型時OOM(Out of Memory),請選擇內存更大的機型。

torch.cuda.OutOfMemoryError: CUDA out of memory

當前機型顯存不足,需要選擇顯存更大的GPU機型或者降低涉及顯存的相關超參數配置,如:lora dim,batch size。

ValueError: No closing quotation

提供的system prompt(也可能是其他參數)中出現了單個

",導致算法生成training command失敗。需要刪除單個",或補齊成對出現。機型資源配置相關

Exception: Current loss scale already at minimum - cannot decrease scale anymore. Exiting run

該模型參數格式為BF16,建議使用Ampere或更先進架構的GPU進行模型訓練,例如A10/A100等。使用Ampere之前架構的GPU進行訓練會將參數轉換為FP16格式。

RuntimeError: CUDA error: uncorrectable ECC error encountered

選擇的機型硬件錯誤。可換一個機型訓練,或換個Region嘗試。

MemoryError: WARNING Insufficient free disk space

選擇的機型內存不夠。需更換更大內存的機型。

用戶限制相關

failed to compose dlc job specs, resource limiting triggered, you are trying to use more GPU resources than the threshold

當前用戶同時啟動了過多作業(3個或以上),觸發資源限制。請等待正在運行中的任務完成。