本文介紹如何使用阿里云AMD CPU云服務器(g8a)和龍蜥容器鏡像,基于通義千問Qwen-VL-Chat搭建個人版視覺AI服務助手。

背景信息

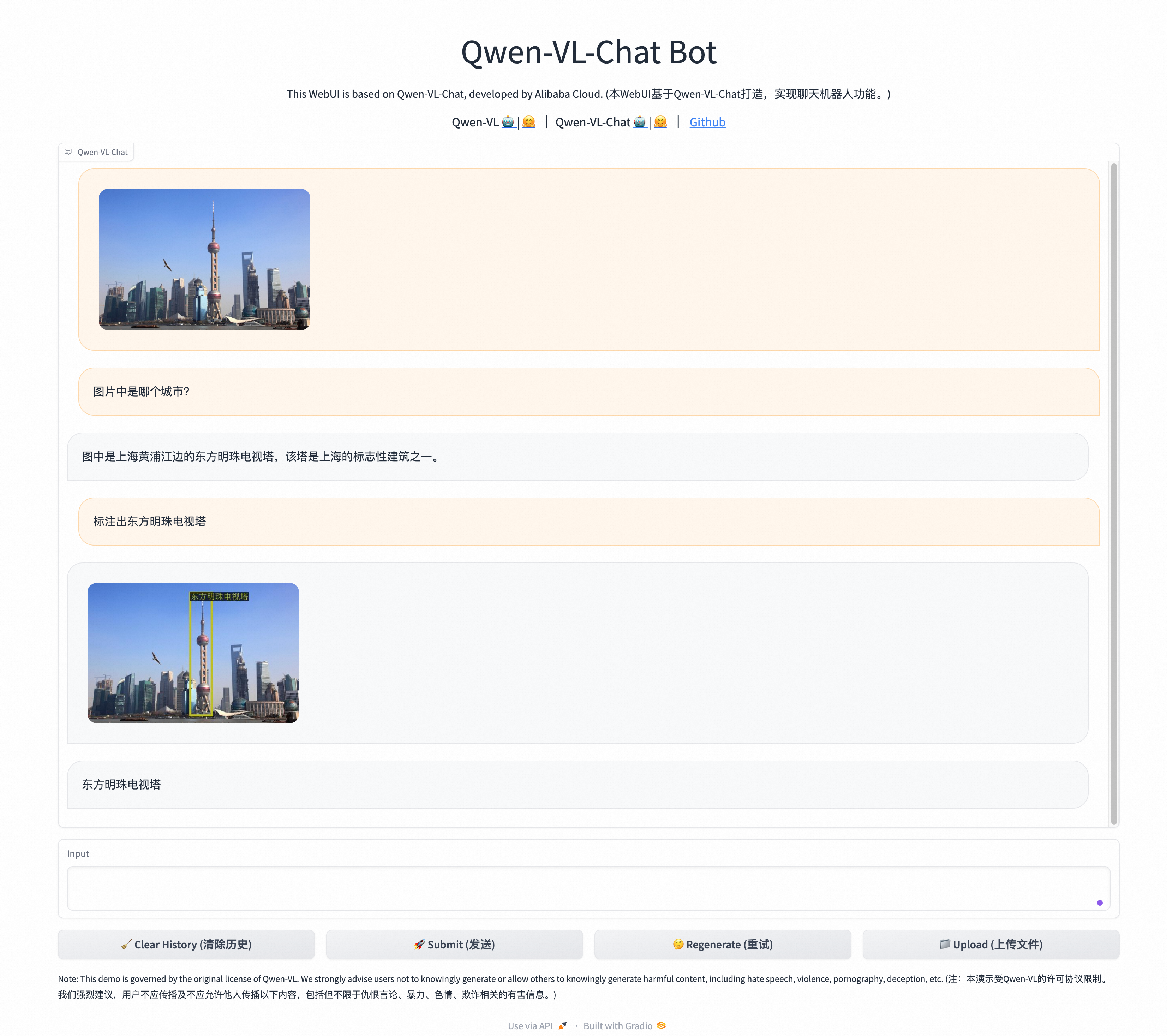

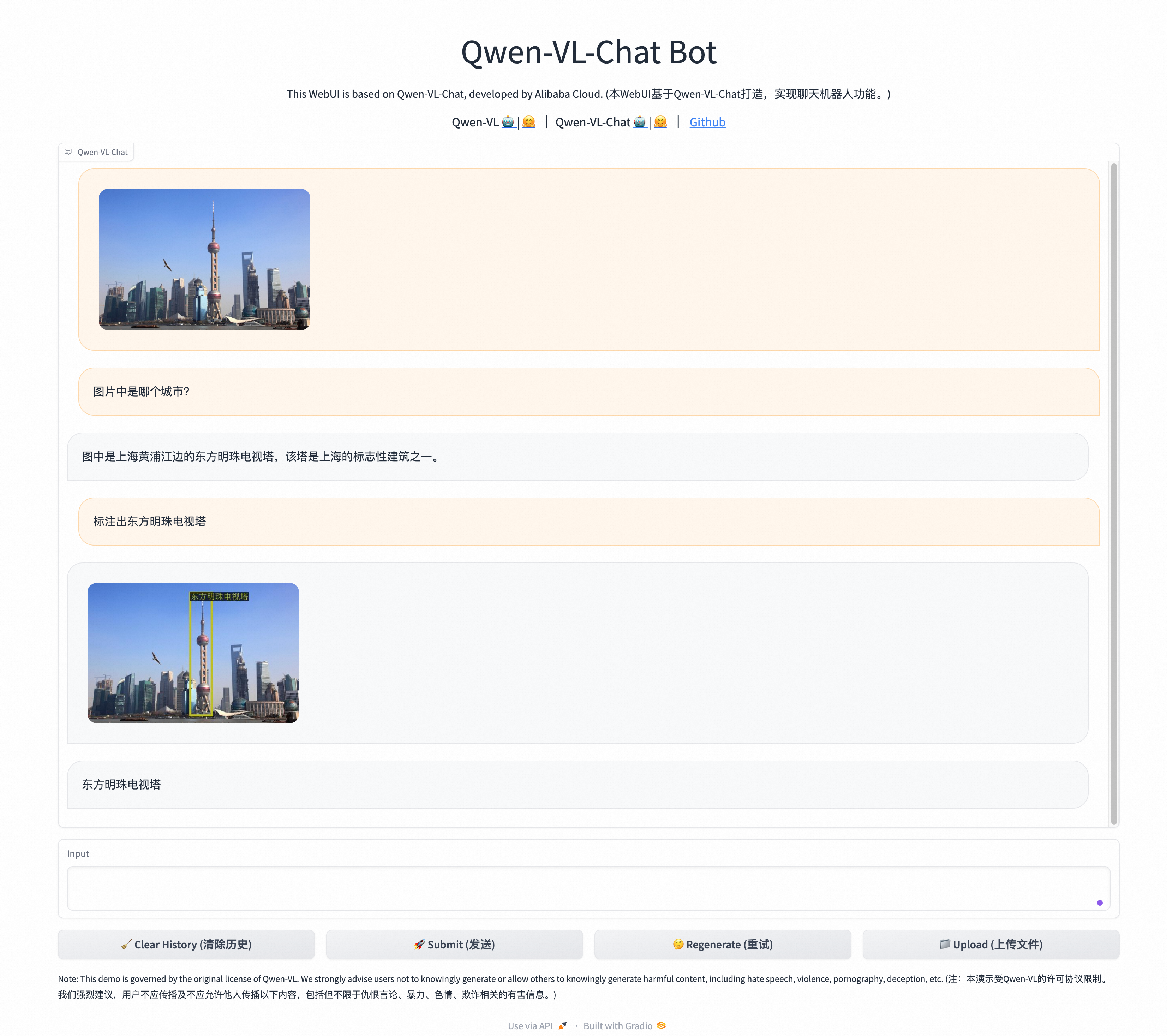

Qwen-VL是阿里云研發的大規模視覺語言模型(Large Vision Language Model)。Qwen-VL可以以圖像、文本、檢測框作為輸入,并以文本和檢測框作為輸出。在Qwen-VL的基礎上,利用對齊機制打造出基于大語言模型的視覺AI助手Qwen-VL-Chat,它支持更靈活的交互方式,包括多圖、多輪問答、創作等能力,天然支持英文、中文等多語言對話,支持多圖輸入和比較,指定圖片問答,多圖文學創作等。

創建ECS實例

前往實例創建頁。

按照界面提示完成參數配置,創建一臺ECS實例。

需要注意的參數如下,其他參數的配置,請參見自定義購買實例。

實例:Qwen-VL-Chat模型的推理過程需要耗費大量的計算資源,運行時占用大量內存,為了保證模型運行的穩定,實例規格至少需要選擇ecs.g8a.4xlarge(64 GiB內存)。

鏡像:Alibaba Cloud Linux 3.2104 LTS 64位。

公網IP:選中分配公網IPv4地址,帶寬計費模式選擇按使用流量,帶寬峰值設置為100 Mbps。以加快模型下載速度。

系統盤:Qwen-VL-Chat的運行需要下載多個模型文件,會占用大量存儲空間,為了保證模型順利運行,建議系統盤設置為100 GiB。

添加安全組規則。

在ECS實例安全組的入方向添加安全組規則并放行22、443、7860端口(用于訪問WebUI服務)。具體操作,請參見添加安全組規則。

創建完成后,在ECS實例頁面,獲取公網IP地址。

說明公網IP地址用于進行AI對話時訪問WebUI服務。

創建Docker運行環境

遠程連接該ECS實例。

具體操作,請參見通過密碼或密鑰認證登錄Linux實例。

安裝Docker。

具體操作,請參見在Alibaba Cloud Linux 3實例中安裝Docker。

創建并運行PyTorch AI容器。

龍蜥社區提供了豐富的基于Anolis OS的容器鏡像,包括針對AMD優化過的PyTorch鏡像,您可以直接使用該鏡像創建一個PyTorch運行環境。

以下命令首先拉取容器鏡像,隨后使用該鏡像創建一個以分離模式運行的、名為

pytorch-amd的容器,并將用戶的家目錄映射到容器中,以保留開發內容。sudo docker pull registry.openanolis.cn/openanolis/pytorch-amd:1.13.1-23-zendnn4.1 sudo docker run -d -it --name pytorch-amd --net host -v $HOME:/root registry.openanolis.cn/openanolis/pytorch-amd:1.13.1-23-zendnn4.1

部署Qwen-VL-Chat

手動部署

步驟一:安裝配置模型所需軟件

進入容器環境。

sudo docker exec -it -w /root pytorch-amd /bin/bash重要后續命令需在容器環境中執行,如意外退出,請使用以上命令重新進入容器環境。如需查看當前環境是否為容器,可以執行

cat /proc/1/cgroup | grep docker查詢(有回顯信息則為容器環境)。安裝部署Qwen-VL-Chat所需的軟件。

yum install -y git git-lfs wget tmux gperftools-libs anolis-epao-release啟用Git LFS。

下載預訓練模型需要Git LFS的支持。

git lfs install

步驟二:下載源碼與模型

創建一個tmux session。

tmux說明下載預訓練模型耗時較長,且成功率受網絡情況影響較大,建議在tmux session中下載,以免ECS斷開連接導致下載模型中斷。

下載Qwen-VL-Chat項目源碼,以及預訓練模型。

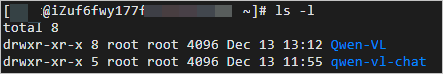

git clone https://github.com/QwenLM/Qwen-VL.git git clone https://www.modelscope.cn/qwen/Qwen-VL-Chat.git qwen-vl-chat查看當前目錄。

ls -l下載完成后,當前目錄顯示如下。

步驟三:部署運行環境

更換pip下載源。

在安裝依賴包之前,建議您更換pip下載源以加速安裝。

創建pip文件夾。

mkdir -p ~/.config/pip配置pip安裝鏡像源。

cat > ~/.config/pip/pip.conf <<EOF [global] index-url=http://mirrors.cloud.aliyuncs.com/pypi/simple/ [install] trusted-host=mirrors.cloud.aliyuncs.com EOF

安裝Python運行依賴。

yum install -y python3-transformers python-einops pip install tiktoken transformers_stream_generator accelerate gradio設置環境變量

OMP_NUM_THREADS和GOMP_CPU_AFFINITY。ZenDNN運行庫需要針對硬件平臺顯式設置環境變量

OMP_NUM_THREADS和GOMP_CPU_AFFINITY。cat > /etc/profile.d/env.sh <<EOF export OMP_NUM_THREADS=\$(nproc --all) export GOMP_CPU_AFFINITY=0-\$(( \$(nproc --all) - 1 )) EOF source /etc/profile

步驟四:進行AI對話

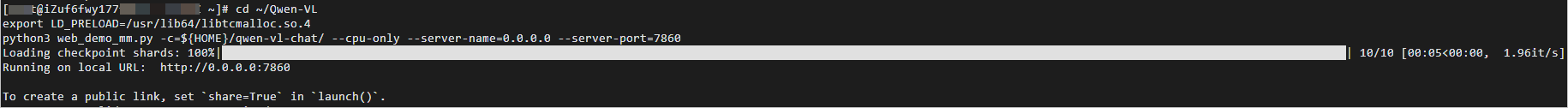

執行如下命令,開啟WebUI服務。

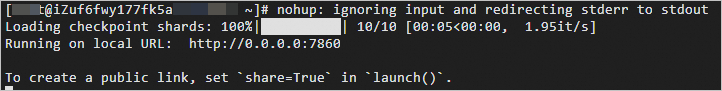

cd ~/Qwen-VL export LD_PRELOAD=/usr/lib64/libtcmalloc.so.4 python3 web_demo_mm.py -c=${HOME}/qwen-vl-chat/ --cpu-only --server-name=0.0.0.0 --server-port=7860當出現如下信息時,表示WebUI服務啟動成功。

在瀏覽器地址欄輸入

http://<ECS公網IP地址>:7860,進入Web頁面。單擊Upload(上傳文件)上傳圖片,然后在Input對話框中,輸入對話內容,單擊Submit(發送),即可開始圖片問答、圖片檢測框標注等。

說明以下示例遠非Qwen-VL-Chat能力的極限,您可以通過更換不同的輸入圖像和提示詞(Prompt),來進一步挖掘Qwen-VL-Chat的能力。

自動化部署

阿里云提供了自動部署腳本,可以一鍵部署運行Qwen-VL-Chat模型。

下載自動部署腳本。

wget https://help-static-aliyun-doc.aliyuncs.com/file-manage-files/en-US/20231213/owpj/deploy_qwen-vl-chat_amd-docker.sh進入容器環境。

sudo docker exec -it -w /root pytorch-amd /bin/bash重要后續命令需在容器環境中執行,如意外退出,請使用以上命令重新進入容器環境。如需查看當前環境是否為容器,可以執行

cat /proc/1/cgroup | grep docker查詢(有回顯信息則為容器環境)。下載tmux并創建一個tmux session。

yum install -y tmux tmux說明該腳本運行中會下載模型文件,耗時較長,建議在tmux session中啟動部署,以免ECS斷開連接導致部署中斷。

為自動化部署腳本添加執行權限。

chmod +x deploy_qwen-vl-chat_amd-docker.sh運行自動化部署腳本。

./deploy_qwen-vl-chat_amd-docker.sh當顯示結果如下所示時,說明自動部署腳本已完成。

說明

說明該腳本運行時間較長,在tmux session中進行部署的過程中,如果斷開了ECS連接,重新登錄ECS實例后執行

tmux attach命令即可恢復tmux session,查看腳本運行進度。在瀏覽器地址欄輸入

http://<ECS公網IP地址>:7860,進入Web頁面。單擊Upload(上傳文件),然后在Input對話框中,輸入對話內容,單擊Submit(發送),即可開始圖片問答、圖片檢測框標注等操作。

說明以下示例遠非Qwen-VL-Chat能力的極限,您可以通過更換不同的輸入圖像和提示詞(Prompt),來進一步挖掘Qwen-VL-Chat的能力。