通過創建Hudi數據源能夠實現Dataphin讀取Hudi的業務數據或向Hudi寫入數據。本文為您介紹如何創建Hudi數據源。

背景信息

Hudi即Apache Hudi,Hudi是一個通用的大數據存儲系統,將核心倉庫和數據庫功能直接引入到數據庫中,并支持記錄級別的插入更新和刪除數據的能力。更多詳情請參見Apache Hudi官網。

權限說明

僅支持具備新建數據源權限點的自定義全局角色和超級管理員、數據源管理員、板塊架構師、項目管理員角色創建數據源。

操作步驟

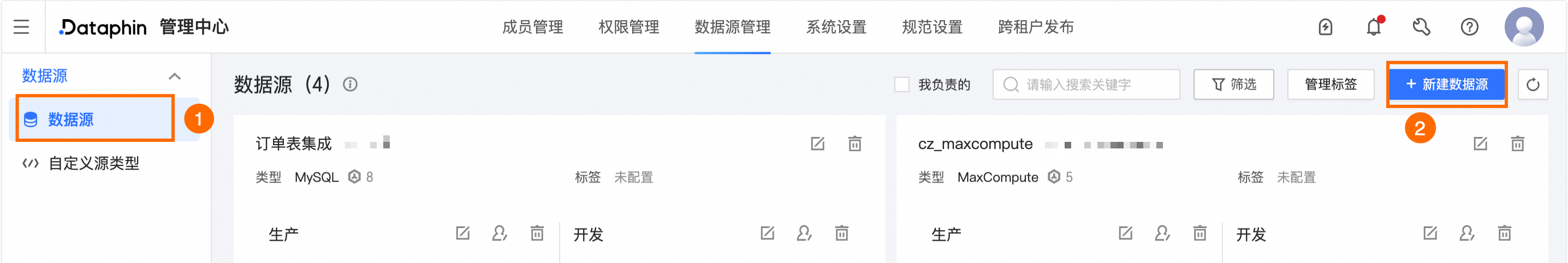

在Dataphin首頁,單擊頂部菜單欄管理中心 > 數據源管理。

在數據源頁面,單擊+新建數據源。

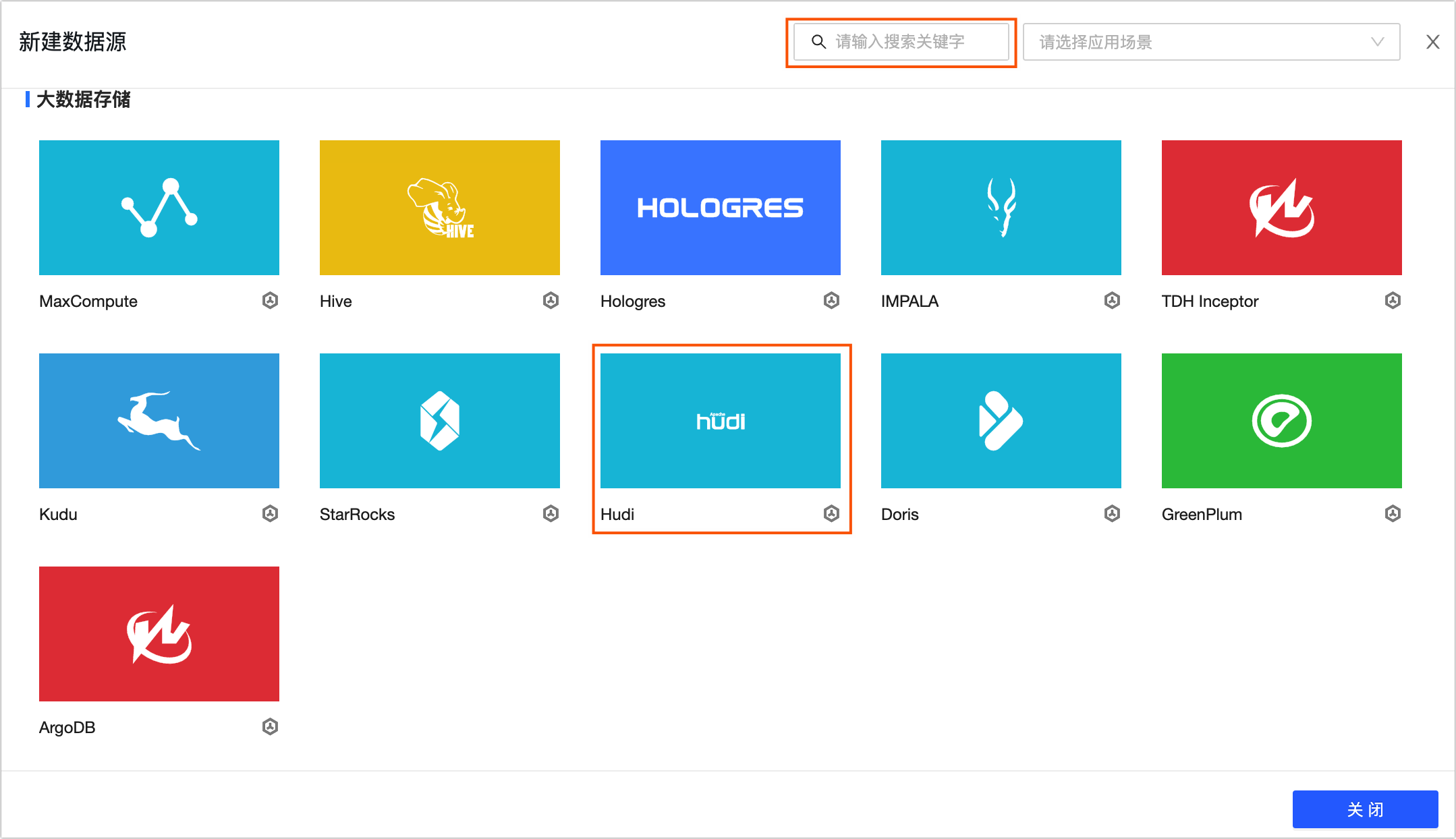

在新建數據源對話框的大數據存儲區域,選擇Hudi。

如果您最近使用過Hudi,也可以在最近使用區域選擇Hudi。同時,您也可以在搜索框中,輸入Hudi的關鍵詞,快速搜索。

在新建Hudi數據源對話框中,配置連接數據源參數。

配置數據源的基本信息。

參數

描述

數據源名稱

命名規則如下:

只能包含中文、英文字母大小寫、數字、下劃線(_)或短劃線(-)。

長度不能超過64字符。

數據源編碼

配置數據源編碼后,您可以在Flink_SQL任務中通過

數據源編碼.表名稱或數據源編碼.schema.表名稱的格式引用數據源中的表;如果需要根據所處環境自動訪問對應環境的數據源,請通過${數據源編碼}.table或${數據源編碼}.schema.table的變量格式訪問。更多信息,請參見Flink_SQL任務開發方式。重要目前僅支持MySQL、Hologres、MaxCompute數據源。

數據源編碼配置成功后不支持修改。

數據源描述

對數據源簡單的描述。不得超過128個字符。

數據源配置

選擇需要配置的數據源:

如果業務數據源區分生產數據源和開發數據源,則選擇生產+開發數據源。

如果業務數據源不區分生產數據源和開發數據源,則選擇生產數據源。

配置數據源與Datahpin的連接參數。

若您的數據源配置選擇生產+開發數據源,則需配置生產+開發數據源的連接信息。如果您的數據源配置為生產數據源,僅需配置生產數據源的連接信息。

說明通常情況下,生產數據源和開發數據源需配置非同一個數據源,以使開發數據源與生產數據源的環境隔離,降低開發數據源對生產數據源的影響。但Dataphin也支持配置成同一個數據源,即相同參數值。

參數

描述

存儲配置

支持HDFS或OSS存儲。

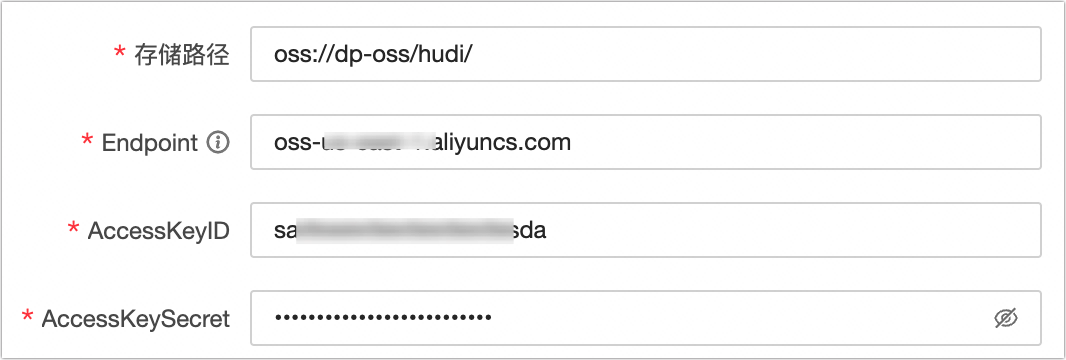

存儲路徑

HDFS存儲:填寫HDFS存儲路徑,請確保flink用戶有訪問路徑的權限。格式為:

hdfs://host:port/path。OSS存儲:填寫OSS存儲路徑。填寫示例:

oss://dp-oss/hudi/。若使用OSS存儲還需填寫OSS的Endpoint、AccessKeyID、AccessKeySecret。

Endpoint:若使用阿里云OSS,您可根據OSS的所在地域,選擇對應的網絡類型進行填寫。詳情請參見查看公共云下OSS Region和Endpoint對照表。

AccessKeyID、AccessKeySecret:OSS所在賬號的AccessKey ID和AccessKey Secret。如何獲取,請參見獲取AccessKey。

元數據同步

開啟后將會同步Hudi表的schema到Hive MetaStore中。

若您使用HDFS存儲配置,開啟元數據同步后,還需配置以下信息:

版本:支持CDH6:2.1.1、CDP7.1.3:3.1.300。

同步模式:支持hms和jdbc。各同步模式需配置不同參數:

hms:Hive元數據庫的thrift地址、同步到Hive的數據庫名稱。

重要如果選擇hms,則hive需開啟metastore server。

jdbc:Hive元數據庫的jdbc地址、Hive元數據庫的用戶名、Hive元數據庫的密碼、同步到Hive的數據庫名稱。

若您使用OSS存儲配置,開啟元數據同步后,還需配置以下信息:

同步模式:默認為hms,不支持修改。

元數據目標庫:默認為DLF,不支持修改。

DLF服務的地域名:填寫DLF服務的地域域名。詳情請參見DLF Region和Endpoint對照表。

DLF服務的Endpoint:填寫DLF服務的Endpoint地址。詳情請參見DLF Region和Endpoint對照表。

同步到Hive的數據庫名稱:填寫同步到Hive的數據庫名稱。

單擊確定,完成Hudi數據源的創建。

重要創建Hudi數據源時不支持測試數據源是否可以和Dataphin進行正常的連通,因此需要您確保連接信息的正確性。您可根據網絡連通解決方案自行排查。