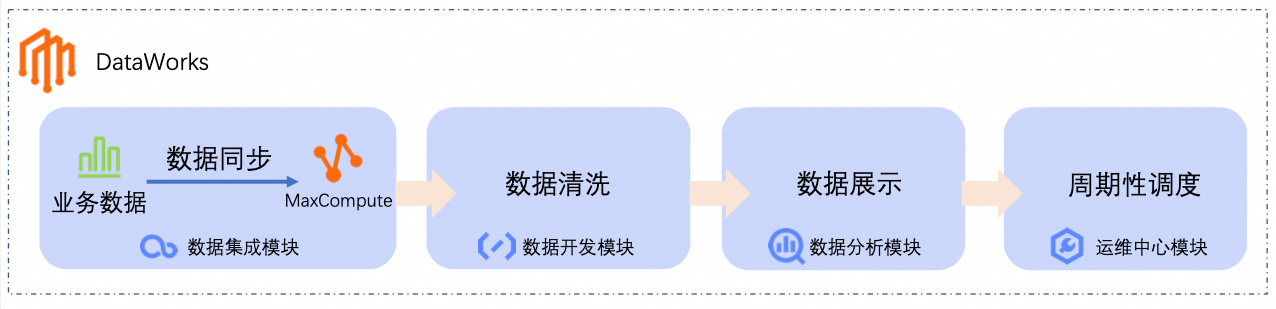

DataWorks基于MaxCompute、Hologres、EMR、AnalyticDB、CDP等大數據引擎,為數據倉庫、數據湖、湖倉一體等解決方案提供統一的全鏈路大數據開發治理平臺。本文以DataWorks的部分核心功能為例,指導您使用DataWorks接入數據并進行業務處理、周期調度以及數據可視化。

入門簡介

通過本快速入門,您可以快速完成以下操作。

數據同步:通過DataWorks的數據集成模塊,創建離線同步任務,將業務數據同步至大數據計算平臺(如MaxCompute數倉)。

數據清洗:在DataWorks的數據開發模塊中,對業務數據進行處理、分析和挖掘。

數據展示:在DataWorks的數據分析模塊中,將分析結果轉化為圖表,便于業務人員理解。

周期性調度:為數據同步和數據清洗流程配置周期性調度,使其定時執行。

前提條件

為確保本教程可以順利進行,推薦使用阿里云主賬號或具備AliyunDataWorksFullAccess權限的RAM用戶。具體操作,請參見準備阿里云賬號(主賬號)或準備RAM用戶(子賬號)。

DataWorks提供了完善的權限管控機制,支持在產品級與模塊級對權限進行管控,如果您需要更精細的權限控制,請參見DataWorks權限體系功能概述。

準備工作

創建工作空間并綁定資源組。

本教程以華東2(上海)地域為例,介紹DataWorks快速入門,您需要登錄DataWorks管理控制臺,切換至華東2(上海)地域,查看該地域是否開通DataWorks。

說明本教程以華東2(上海)為例,在實際使用中,請根據實際業務數據所在位置確定開通地域:

如果您的業務數據位于阿里云的其他云服務,請選擇與其相同的地域。

如果您的業務在本地,需要通過公網訪問,請選擇與您實際地理位置較近的地域,以降低訪問延遲。

如果未開通,單擊0元組合購買,通過組合購買,一站式完成DataWorks開通、默認空間創建以及資源組綁定。

配置組合購買頁相關參數。

參數

說明

示例

地域

選擇需要開通DataWorks的地域。

華東2(上海)

DataWorks

選擇需要購買的DataWorks版本。

說明本教程以基礎版為例,所有版本均可體驗本教程所涉及的功能,您可以參考DataWorks各版本支持的功能詳情,根據實際業務需要,選擇合適的DataWorks版本。

基礎版

DataWorks資源組

通過DataWorks進行數據集成、數據開發、數據調度等任務時,需要消耗計算資源,您需要配套購買資源組,以確保后續任務的順利運行。

付費模式:按量付費

資源組名稱:自定義

專有網絡(VPC)、交換機(V-Switch):選擇已有的VPC和交換機。

說明如當前地域沒有可用的VPC和交換機,請單擊參數說明中對應的控制臺鏈接前往創建。VPC和交換機的更多信息,請參見什么是專有網絡。

服務關聯角色:根據頁面提示,創建服務關聯角色。

勾選服務協議后,單擊確認訂單并支付,完成后續支付。

說明完成購買后,系統將自動創建工作空間和資源組,并將資源組綁定至工作空間。

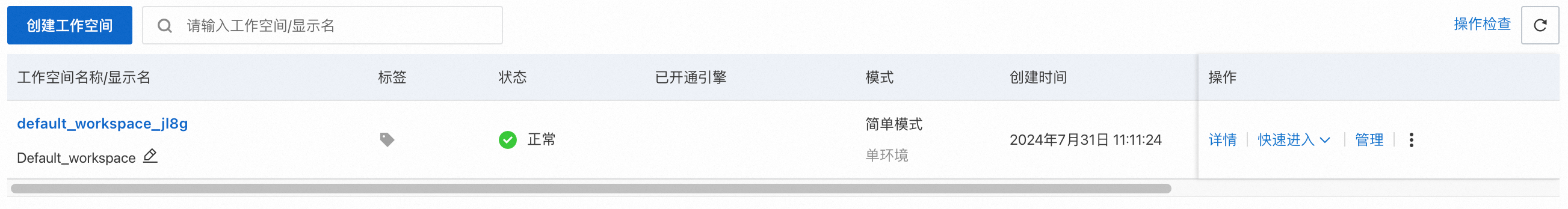

你可以前往DataWorks工作空間列表,切換至華東2(上海)地域,查看已創建的工作空間。

如果已開通,則需要手動創建本次教程使用的工作空間、資源組及資源組綁定操作。

創建工作空間。

單擊DataWorks管理控制臺左側導航欄的工作空間,進入工作空間列表頁面,然后單擊創建工作空間。

在創建工作空間頁面,自定義工作空間名稱,然后單擊創建工作空間。

創建資源組。

單擊DataWorks管理控制臺左側導航欄的資源組,進入資源組列表,然后單擊新建資源組。

在DataWorks通用資源組(按量付費)頁面,配置如下參數。

參數

說明

資源組名稱

自定義。

專有網絡(VPC)、交換機(V-Switch)

選擇已有的VPC和交換機,如當前地域沒有,請單擊參數說明中對應的控制臺鏈接前往創建。

服務關聯角色

根據頁面提示,創建DataWorks服務關聯角色。

單擊立即購買,完成后續支付。

為工作空間綁定資源組。

單擊DataWorks管理控制臺左側導航欄的資源組,進入資源組列表頁面,找到已創建的資源組,單擊操作列的。

在綁定工作空間頁面,找到已創建的DataWorks工作空間,單擊其操作列的綁定。

為資源組綁定的VPC配置EIP。

本教程使用的電商平臺公開測試業務數據需要通過公網獲取,而上一步創建的通用型資源組默認不具備公網訪問能力,需要為資源組綁定的VPC配置公網NAT網關,添加EIP,使其與公開數據網絡打通,從而獲取數據。

登錄專有網絡-公網NAT網關控制臺,在頂部菜單欄切換至華東2(上海)地域。

單擊創建公網NAT網關。配置相關參數。

參數

取值

所屬地域

華東2(上海)。

所屬專有網絡

選擇資源組綁定的VPC和交換機。

您可以前往DataWorks管理控制臺,切換地域后,在左側導航欄單擊資源組列表,找到已創建的資源組,然后單擊操作列的網絡設置,在數據調度 & 數據集成區域查看綁定專有網絡和交換機。VPC和交換機的更多信息,請參見什么是專有網絡。

關聯交換機

訪問模式

VPC全通模式(SNAT)。

彈性公網IP實例

新購彈性公網IP。

關聯角色創建

首次創建NAT網關時,需要創建服務關聯角色,請單擊創建關聯角色。

說明上表中未說明的參數保持默認值即可。

單擊立即購買,勾選服務協議后,單擊立即開通,完成購買。

操作步驟

本文以如下場景為例,指導您快速體驗DataWorks的相關功能:

假設某一電商平臺將商品信息、訂單信息存儲在MySQL數據庫中,需要定期對訂單數據進行分析,通過可視化的方式查看每日最暢銷商品類目排名表。

步驟一:數據同步

創建數據源。

DataWorks通過創建數據源的方式,接入數據來源和數據去向,因此,本步驟需要分別創建MySQL和MaxCompute兩個數據源。

MySQL數據源,用于連接數據來源(存儲業務數據的MySQL數據庫),為本教程提供原始業務數據。

說明您無需準備本教程使用的原始業務數據,為方便測試和學習,DataWorks為您提供測試數據集,相關表數據已存儲在公網MySQL數據庫中,您只需創建MySQL數據源接入即可。

進入管理中心頁面。

登錄DataWorks控制臺,切換至目標地域后,單擊左側導航欄的,在下拉框中選擇對應工作空間后單擊進入管理中心。

在左側導航欄單擊,然后單擊新增數據源,選擇數據源類型為MySQL數據源。

配置MySQL數據源相關參數。

說明表中未說明的參數保持默認值即可。

首次新增數據源時,需要完成跨服務授權,請根據頁面提示,授權服務關聯角色AliyunDIDefaultRole。

參數

描述

數據源名稱

本示例為MySQL_Source。

配置模式

選擇連接串模式。

連接地址

單擊新增地址。

主機地址IP:

rm-bp1z69dodhh85z9qa.mysql.rds.aliyuncs.com端口號:

3306。

重要本教程提供的數據僅作為阿里云大數據開發治理平臺 DataWorks數據應用實操使用,所有數據均為測試數據,并且僅支持在數據集成模塊讀取數據。

數據庫名稱

配置為

retail_e_commerce。用戶名

輸入用戶名

workshop。密碼

輸入密碼

workshop#2017。在連接配置區域,找到工作空間已綁定的資源組,單擊連通狀態列的測試連通性。

說明如果MySQL數據源連通性測試失敗,請檢查是否為資源組綁定的VPC配置EIP,MySQL數據源需要資源組具備公網訪問能力。

單擊完成創建。

MaxCompute數據源,用于連接數據去向(MaxCompute數倉),將MaxCompute數據源綁定至數據開發后,能夠為本教程提供數據存儲和計算能力。

如果您的項目空間中存在已添加的MaxCompute數據源,則無需進行此步驟。

如果您的項目空間中沒有添加MaxCompute數據源,在參考如下步驟創建。

在管理中心左側導航欄單擊,然后單擊新增數據源,選擇數據源類型為MaxCompute數據源。

配置MaxCompute數據源相關參數。

說明表中未說明的參數保持默認值即可。

參數

描述

數據源名稱

本示例為MaxCompute_Source。

地域

選擇MaxCompute數據源所在地域。

MaxCompute項目名稱

選擇創建MaxCompute項目。

計算資源付費類型

選擇按量付費。

說明如果按量付費不可選,請單擊按量付費后的去開通,完成MaxCompute服務的開通。

默認Quota

下拉選擇默認已存在的Quota。

默認訪問身份

阿里云主賬號。

在連接配置區域,找到工作空間已綁定的資源組,單擊連通狀態列的測試連通性。

說明MaxCompute項目名稱全局唯一,如測試連通性不通過,報錯提示為

ErrorMessage:[ODPS-0420095: Access Denied - Authorization Failed [4002], You don't exist in project xxx.,是因為項目名稱已存在,請修改項目名稱后再試。單擊完成創建。

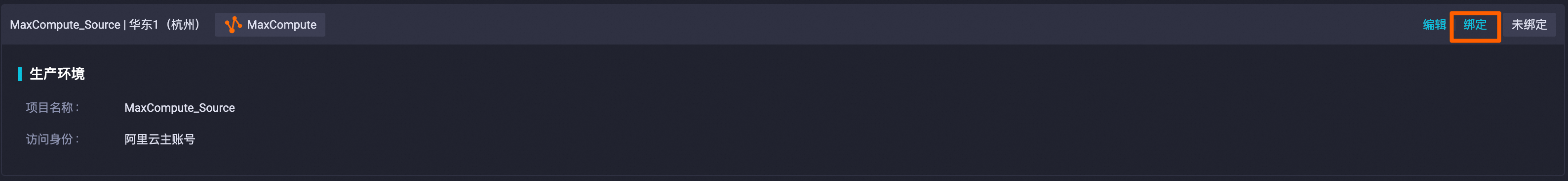

數據開發綁定MaxCompute數據源。

需要先將MaxCompute數據源綁定至數據開發,后續才能在數據開發模塊中對MaxCompute的數據進行處理。

單擊左上角

圖標,在彈出頁面中單擊。

圖標,在彈出頁面中單擊。在左側導航欄單擊數據源(

),找到已創建的MaxCompute數據源,單擊綁定。說明

),找到已創建的MaxCompute數據源,單擊綁定。說明如果您的數據開發模塊已綁定了MaxCompute數據源,則無需進行此步驟。

創建虛擬節點,用于統籌管理整個電商平臺銷售數據分析的業務流程。該節點為空跑任務,無須編輯代碼。

在左側導航欄單擊

圖標,進入數據開發頁面,找到,然后右鍵Workflow,選擇,自定義節點名稱,本教程以

圖標,進入數據開發頁面,找到,然后右鍵Workflow,選擇,自定義節點名稱,本教程以Workshop為例。創建離線同步任務。

本教程使用的測試數據涉及兩張表(商品信息源表

item_info和訂單信息源表trade_order),這兩張表存儲于MySQL數據源關聯的MySQL數據庫中,本步驟需要分別創建兩個離線同步節點(節點名稱以ods_item_info和ods_trade_order為例),用于將item_info表和trade_order表同步至MaxCompute數據源關聯的MaxCompute數倉中,然后再進行后續數據開發。右鍵Workflow,選擇。

在新建節點頁面,設置名稱為ods_item_info。

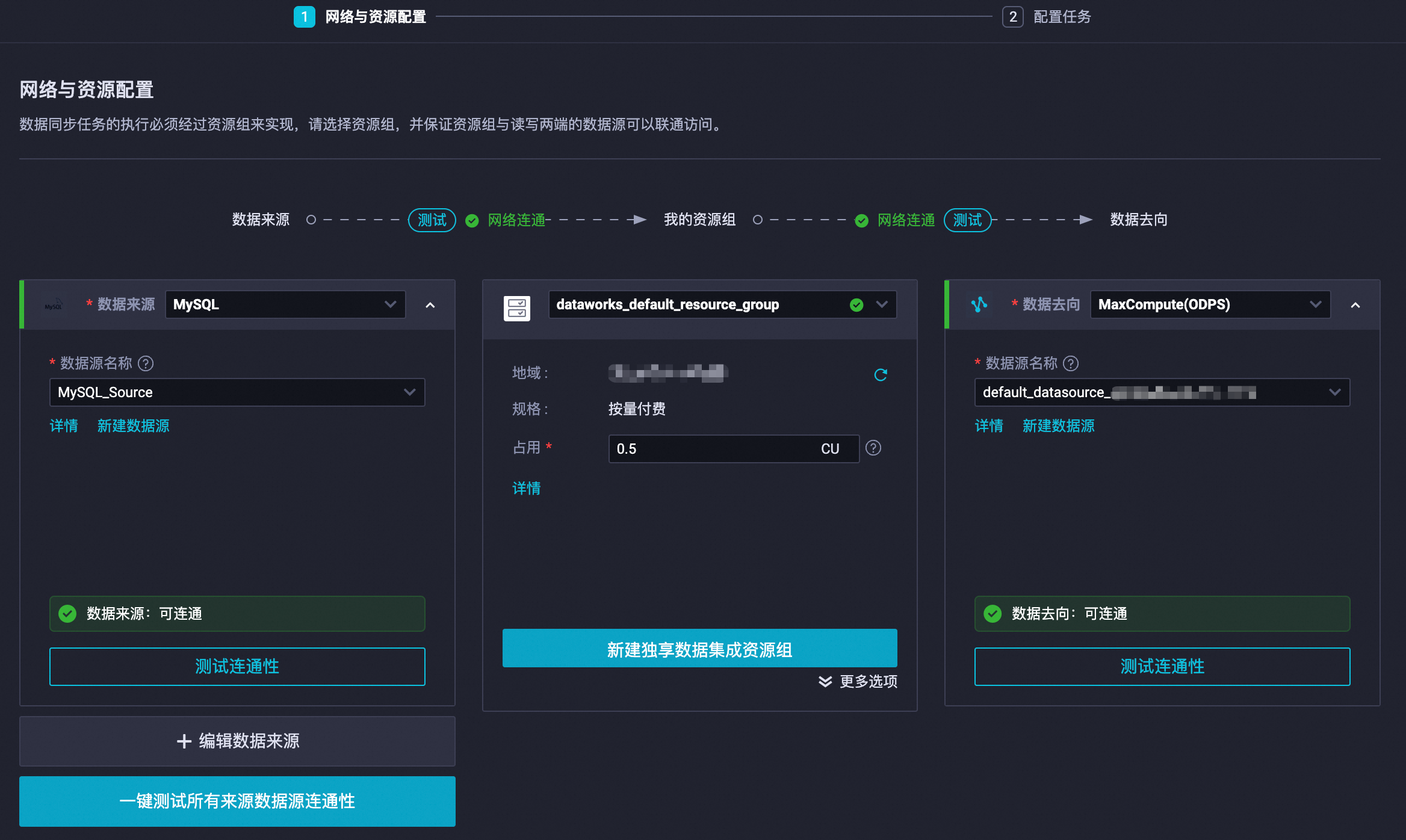

配置數據來源為已創建的MySQL數據源,數據去向為已綁定至數據開發的MaxCompute數據源,中間的資源組選擇工作空間已綁定的資源組,然后測試連通性都為可連通后,單擊下一步。

配置數據來源和數據去向的相關參數。

說明表中未說明的參數保持默認值即可。

配置區域

參數

ods_item_info離線同步節點取值

數據來源

表

item_info數據去向

表

單擊一鍵生成目標表結構,在新建表窗口中,修改建表語句,將表名修改為

ods_item_info,然后單擊新建表。通道控制

臟數據策略

配置為不容忍臟數據。

單擊離線同步任務配置窗口頂部的保存(

),然后單擊帶參運行(

),然后單擊帶參運行( )。重要

)。重要在離線計算場景下,

bizdate為業務交易發生的日期,也常被稱為業務日期(business date)。例如,今天統計前一天的營業額,此處的前一天,指交易發生的日期,也就是業務日期。帶參運行時,自定義參數取值保持默認(當前時間的前一天)即可。如果您在此時修改了

bizdate取值,請在后續本文所有節點涉及帶參運行時,同步修改bizdate取值。

右鍵Workflow,選擇。

在新建節點頁面,設置名稱為ods_trade_order。

配置數據來源為已創建的MySQL數據源,數據去向為已綁定至數據開發的MaxCompute數據源,中間的資源組選擇工作空間已綁定的資源組,然后測試連通性都為可連通后,單擊下一步。

配置數據來源和數據去向的相關參數。

說明表中未說明的參數保持默認值即可。

配置區域

參數

ods_trade_order離線同步節點取值

數據來源

表

trade_order數據去向

表

單擊一鍵生成目標表結構,在新建表窗口中,修改建表語句,將表名修改為

ods_trade_order,然后單擊新建表。通道控制

臟數據策略

配置為不容忍臟數據。

單擊離線同步任務配置窗口頂部的保存(

),然后單擊帶參運行(

),然后單擊帶參運行( )。

)。

步驟二:數據清洗

數據已從MySQL同步至MaxCompute后,獲得兩張數據表(商品信息表ods_item_info和訂單信息表ods_trade_order),您可以在DataWorks的數據開發模塊對表中數據進行清洗、處理和分析,從而獲取每日最暢銷商品類目排名表。

運行ODPS節點時,會展示費用預估,由于每一個ODPS節點配置的SQL中同時包括CREATE和INSERT語句,INSERT時,表還未創建,因此可能提示預估費用失敗,請忽略此報錯,直接運行即可。

DataWorks提供調度參數,可實現代碼動態入參,您可在SQL代碼中通過

${變量名}的方式定義代碼中的變量,并在調度配置 > 調度參數處,為該變量賦值。調度參數支持的格式,詳情請參見調度參數支持的格式。本示例SQL中使用了調度參數${bizdate},表示業務日期為前一天。

創建

dim_item_info節點。基于

ods_item_info表,處理商品維度數據,產出商品基礎信息維度表dim_item_info。右鍵Workflow,選擇,在新建節點頁面,設置名稱為

dim_item_info后,單擊確認,配置如下SQL。CREATE TABLE IF NOT EXISTS dim_item_info ( gmt_modified STRING COMMENT '商品最后修改日期', gmt_create STRING COMMENT '商品創建時間', item_id BIGINT COMMENT '商品數字ID', title STRING COMMENT '商品標題', sub_title STRING COMMENT '商品子標題', pict_url STRING COMMENT '主圖URL', desc_path STRING COMMENT '商品描述的路徑', item_status BIGINT COMMENT '商品狀態1:確認通過0:未確認通過', last_online_time DATETIME COMMENT '最近一次開始銷售時間,商品上架時間', last_offline_time DATETIME COMMENT '銷售結束時間,表示一個銷售周期的結束,僅作用于拍賣商品', duration BIGINT COMMENT '有效期,銷售周期,只有兩個值,7天或14天', reserve_price DOUBLE COMMENT '當前價格', secure_trade_ordinary_post_fee DOUBLE COMMENT '平郵費用', secure_trade_fast_post_fee DOUBLE COMMENT '快遞費用', secure_trade_ems_post_fee DOUBLE COMMENT 'EMS郵費', last_online_quantity BIGINT COMMENT '商品最近一次上架時的庫存數量', features STRING COMMENT '商品特征', cate_id BIGINT COMMENT '商品葉子類目ID', cate_name STRING COMMENT '商品葉子類目名稱', commodity_id BIGINT COMMENT '品類ID', commodity_name STRING COMMENT '品類名稱', is_virtual STRING COMMENT '是否虛擬商品', shop_id BIGINT COMMENT '商家ID', shop_nick STRING COMMENT '商家NICK', is_deleted BIGINT COMMENT '類目是否刪除' ) COMMENT '商品基礎信息維度表' PARTITIONED BY (pt STRING COMMENT '業務日期, yyyymmdd') LIFECYCLE 365; -- 插入數據到 dim_item_info 表 INSERT OVERWRITE TABLE dim_item_info PARTITION(pt='${bizdate}') SELECT gmt_create, gmt_modified, item_id, title, sub_title, pict_url, desc_path, item_status, last_online_time, last_offline_time, duration, cast(reserve_price as DOUBLE), cast(secure_trade_ordinary_post_fee as DOUBLE), cast(secure_trade_fast_post_fee as DOUBLE), cast(secure_trade_ems_post_fee as DOUBLE), last_online_quantity, features, cate_id, cate_name, commodity_id, commodity_name, is_virtual, shop_id, shop_nick, is_deleted FROM ods_item_info WHERE pt = '${bizdate}';單擊ODPS SQL配置窗口頂部的保存(

),然后單擊帶參運行(

),然后單擊帶參運行( )。

)。

創建

dwd_trade_order節點。基于

ods_trade_order表,對訂單的詳細交易數據進行初步清洗、轉換和業務邏輯處理,產出交易下單明細事實表dwd_trade_order。右鍵Workflow,選擇,在新建節點頁面,設置名稱為

dwd_trade_order后,單擊確認,配置如下SQL。CREATE TABLE IF NOT EXISTS dwd_trade_order ( id BIGINT COMMENT '主鍵,去重后的最新id', gmt_create DATETIME COMMENT '創建時間', gmt_modified DATETIME COMMENT '修改時間', sub_order_id BIGINT COMMENT '子訂單ID', parent_order_id BIGINT COMMENT '父訂單ID', buyer_id BIGINT COMMENT '買家數字id', buyer_nick STRING COMMENT '買家昵稱,處理空值', item_id BIGINT COMMENT '商品數字id', item_price DECIMAL(38,18) COMMENT '商品價格,單位分', buy_amount BIGINT COMMENT '購買數量', biz_type BIGINT COMMENT '交易類型', memo STRING COMMENT '備注,處理空值', pay_status BIGINT COMMENT '支付狀態', logistics_status BIGINT COMMENT '物流狀態', status BIGINT COMMENT '狀態', seller_memo STRING COMMENT '賣家的給交易的備注', buyer_memo STRING COMMENT '買家給交易的備注', clean_ip STRING COMMENT '清洗后的買家IP,過濾無效格式', end_time DATETIME COMMENT '交易結束時間', pay_time DATETIME COMMENT '付款的時間', is_sub BIGINT COMMENT '是否是子訂單1表示子訂單', is_parent BIGINT COMMENT '是否是父訂單1表示父訂單', shop_id BIGINT COMMENT '商家id', total_fee DECIMAL(38,18) COMMENT '去除折扣和調整后的子訂單費用', is_large_order_flag BOOLEAN COMMENT '是否為大額訂單標志' ) COMMENT '交易下單明細事實表,包含初步清洗和業務邏輯處理' PARTITIONED BY (pt STRING COMMENT '業務日期, yyyymmdd') LIFECYCLE 365; -- 數據生命周期設置為365天 INSERT OVERWRITE TABLE dwd_trade_order PARTITION(pt='${bizdate}') SELECT MAX(id) AS id, -- 假設使用最新的id作為去重標準 gmt_create, gmt_modified, sub_order_id, parent_order_id, buyer_id, COALESCE(buyer_nick, '') AS buyer_nick, -- 處理buyer_nick為空的情況 item_id, item_price, buy_amount, biz_type, COALESCE(memo, '') AS memo, -- 處理memo為空的情況 pay_status, logistics_status, status, seller_memo, buyer_memo, CASE WHEN ip LIKE '__.__.__.__' THEN NULL -- 過濾無效IP格式 ELSE ip END AS clean_ip, end_time, pay_time, is_sub, is_parent, shop_id, total_fee, CASE WHEN total_fee >= 10000 THEN TRUE -- 假設大于10000分的訂單為大額訂單 ELSE FALSE END AS is_large_order_flag -- 添加業務邏輯標志 FROM ( SELECT *, ROW_NUMBER() OVER(PARTITION BY buyer_id, item_id, gmt_create ORDER BY id DESC) AS rn -- 用于去重的行號 FROM ods_trade_order WHERE pt = '${bizdate}' ) AS sub_query WHERE rn = 1 -- 僅保留每個去重組的第一條記錄 GROUP BY gmt_create, gmt_modified, sub_order_id, parent_order_id, buyer_id, buyer_nick, item_id, item_price, buy_amount, biz_type, memo, pay_status, logistics_status, status, seller_memo, buyer_memo, clean_ip, end_time, pay_time, is_sub, is_parent, shop_id, total_fee, is_large_order_flag;單擊ODPS SQL配置窗口頂部的保存(

),然后單擊帶參運行(

),然后單擊帶參運行( )。

)。

創建

dws_daily_category_sales節點。基于

dwd_trade_order表和dim_item_info表,對DWD層經過清洗和標準化的明細數據進行匯總,產出每日商品類目銷售匯總表dws_daily_category_sales。右鍵Workflow,選擇,在新建節點頁面,設置名稱為

dws_daily_category_sales后,單擊確認,配置如下SQL。CREATE TABLE IF NOT EXISTS dws_daily_category_sales ( cate_id BIGINT COMMENT '商品葉子類目ID', cate_name STRING COMMENT '商品葉子類目名稱', total_sales_amount DECIMAL(38,18) COMMENT '商品類目總銷售額,單位分', order_count BIGINT COMMENT '訂單數量' ) COMMENT '每日商品類目銷售匯總表' PARTITIONED BY (pt STRING COMMENT '業務日期, yyyymmdd') LIFECYCLE 365; INSERT OVERWRITE TABLE dws_daily_category_sales PARTITION(pt='${bizdate}') SELECT i.cate_id, i.cate_name, SUM(t.total_fee) AS total_sales_amount, COUNT(DISTINCT t.id) AS order_count FROM dwd_trade_order t JOIN dim_item_info i ON t.item_id = i.item_id AND t.pt = i.pt WHERE t.pt = '${bizdate}' GROUP BY t.pt, i.cate_id, i.cate_name;單擊ODPS SQL配置窗口頂部的保存(

),然后單擊帶參運行(

),然后單擊帶參運行( )。

)。

創建

ads_top_selling_categories節點。基于

dws_daily_category_sales表,產出每日最暢銷商品類目排名表ads_top_selling_categories。右鍵Workflow,選擇,在新建節點頁面,設置名稱為

ads_top_selling_categories后,單擊確認,配置如下SQL。CREATE TABLE IF NOT EXISTS ads_top_selling_categories ( rank BIGINT COMMENT '銷量排名', cate_id BIGINT COMMENT '商品葉子類目ID', cate_name STRING COMMENT '商品葉子類目名稱', total_sales_amount DECIMAL(38,18) COMMENT '商品類目總銷售額,單位分', order_count BIGINT COMMENT '訂單數量' ) COMMENT '每日最暢銷商品類目排名表' PARTITIONED BY (pt STRING COMMENT '業務日期, yyyymmdd'); INSERT OVERWRITE TABLE ads_top_selling_categories PARTITION(pt='${bizdate}') SELECT rank, cate_id, cate_name, total_sales_amount, order_count FROM ( SELECT DENSE_RANK() OVER(ORDER BY total_sales_amount DESC) AS rank, cate_id, cate_name, total_sales_amount, order_count FROM ( SELECT cate_id, cate_name, SUM(total_sales_amount) AS total_sales_amount, SUM(order_count) AS order_count FROM dws_daily_category_sales WHERE pt = '${bizdate}' GROUP BY cate_id, cate_name ) agg_sub ) agg_outer WHERE rank <= 10;單擊ODPS SQL配置窗口頂部的保存(

),然后單擊帶參運行(

),然后單擊帶參運行( )。

)。

步驟三:數據展示

您已經將從MySQL中獲取的原始測試數據,經過數據開發處理,匯總于表ads_top_selling_categories中,現在可查詢表數據,查看數據分析后的結果。

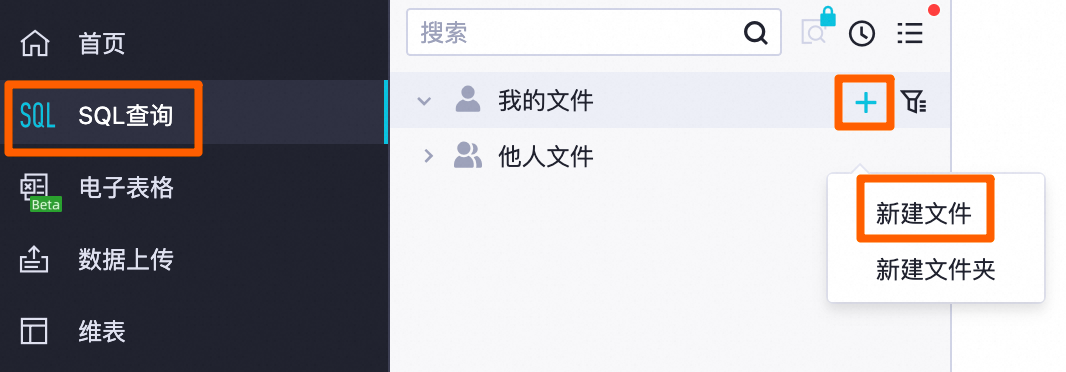

單擊左上角

圖標,在彈出頁面中單擊。

圖標,在彈出頁面中單擊。在我的文件后單擊,自定義文件名后單擊確定。

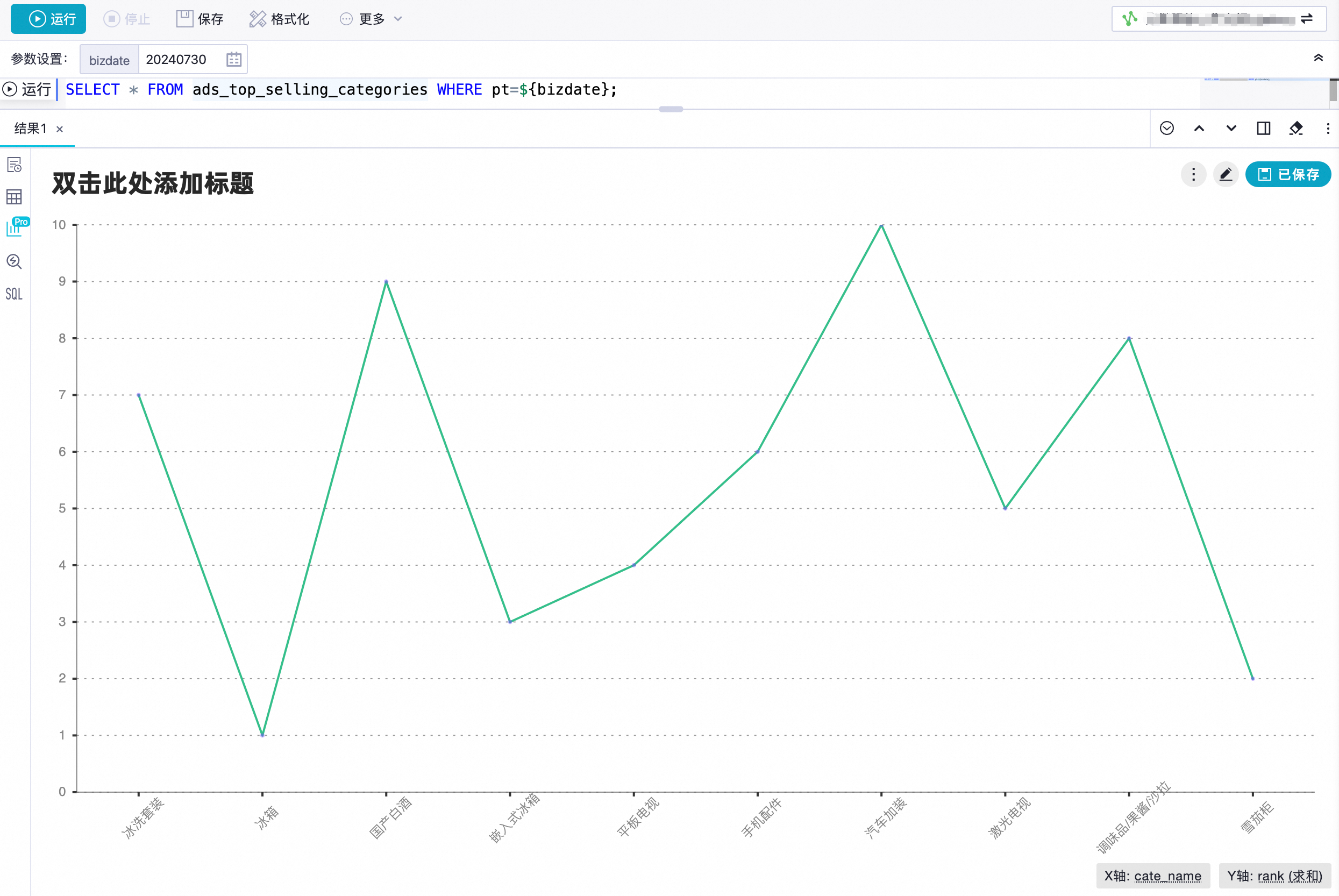

在SQL查詢頁面,配置如下SQL。

SELECT * FROM ads_top_selling_categories WHERE pt=${bizdate};單擊頂部的運行(

),根據頁面提示,在右上角選擇MaxCompute數據源后單擊確定,然后在成本預估頁面,單擊運行。

),根據頁面提示,在右上角選擇MaxCompute數據源后單擊確定,然后在成本預估頁面,單擊運行。在查詢結果中單擊

,查看可視化圖表結果,您可以單擊圖表右上角的

,查看可視化圖表結果,您可以單擊圖表右上角的 自定義圖表樣式。自定義圖表樣式的更多信息,請參見增強分析(卡片和報告)。

自定義圖表樣式。自定義圖表樣式的更多信息,請參見增強分析(卡片和報告)。

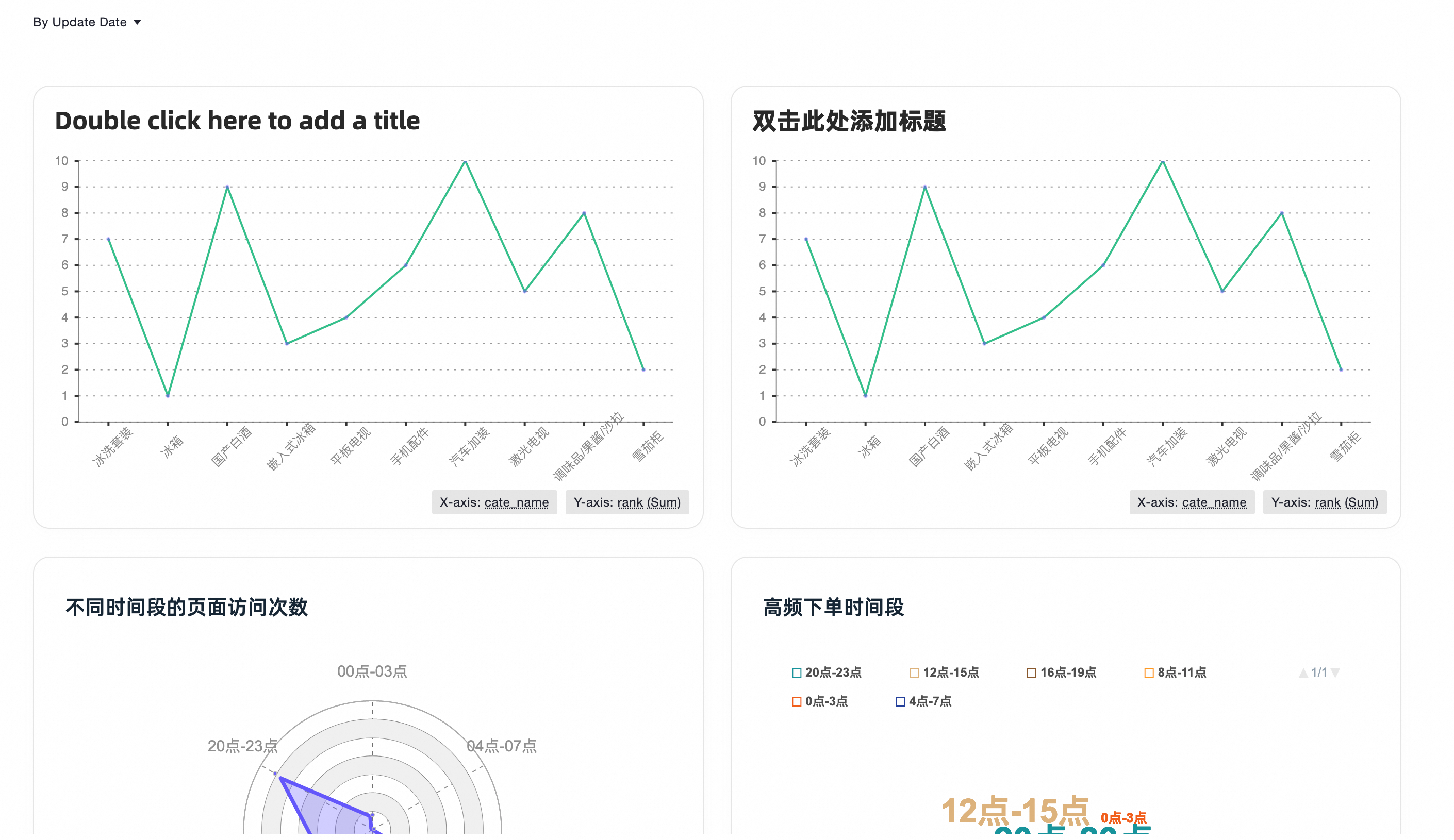

您也可以單擊圖表右上角保存,將圖表保存為卡片,然后在左側導航欄單擊卡片(

)查看。

)查看。

步驟四:周期性調度

通過完成前文操作步驟,您已經獲取了前一天各類商品的銷售數據,但是,如果需要每天獲取最新的銷售數據,則可以為數據開發中各任務節點配置周期任務,使其周期性定時執行。

為簡化操作,快速入門教程以可視化方式為業務流程配置調度,DataWorks還支持手動精細化配置,各任務節點支持根據SQL自動解析上下游依賴,調度配置的更多信息,請參見任務調度配置。

單擊左上角

圖標,在彈出頁面中單擊。

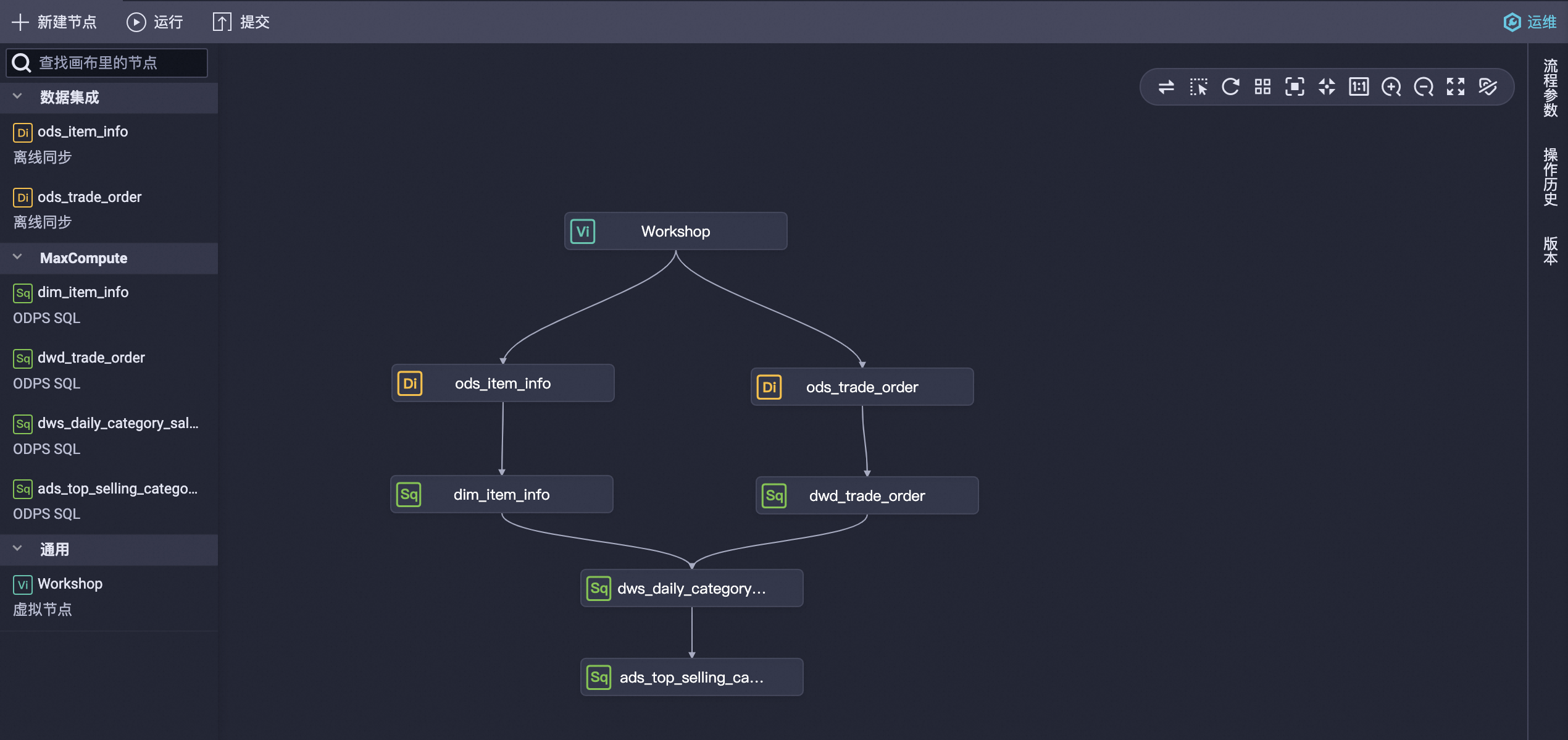

圖標,在彈出頁面中單擊。右鍵單擊業務流程Workflow,單擊看板進入畫布,在畫布中移動各節點位置并按下圖拖拽出各節點的上下游依賴關系。

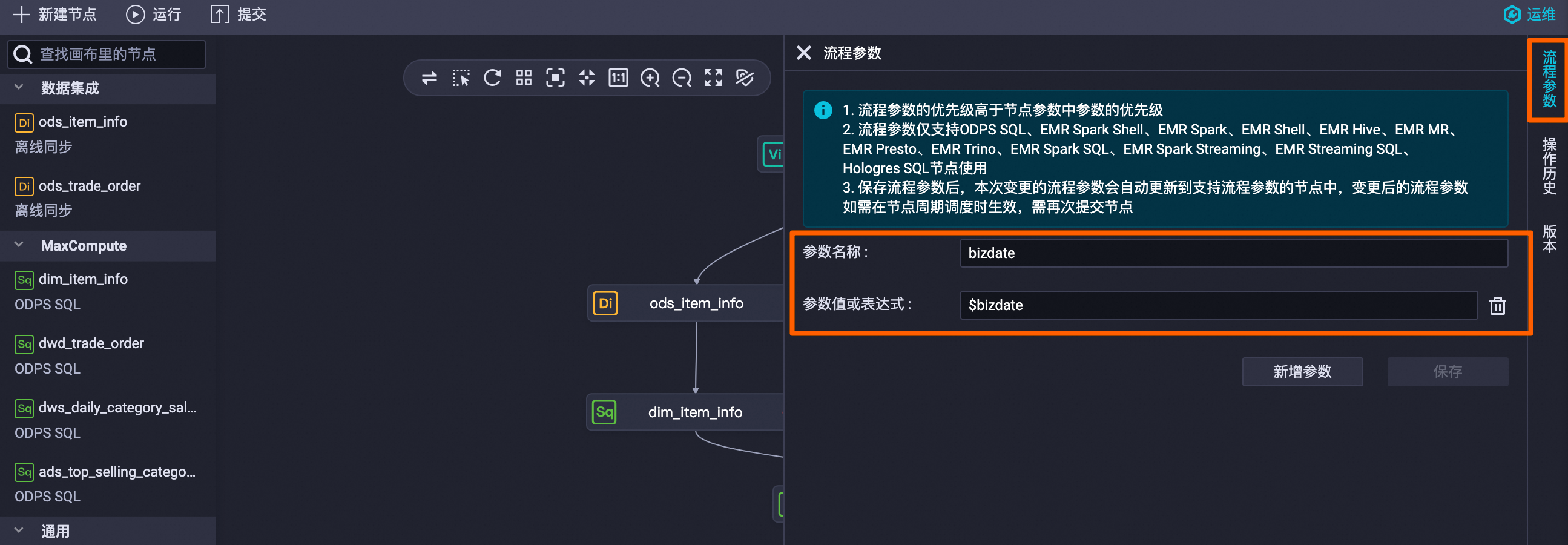

單擊右側流程參數,配置參數名稱為

bizdate,參數值或表達式為$bizdate,單擊保存。

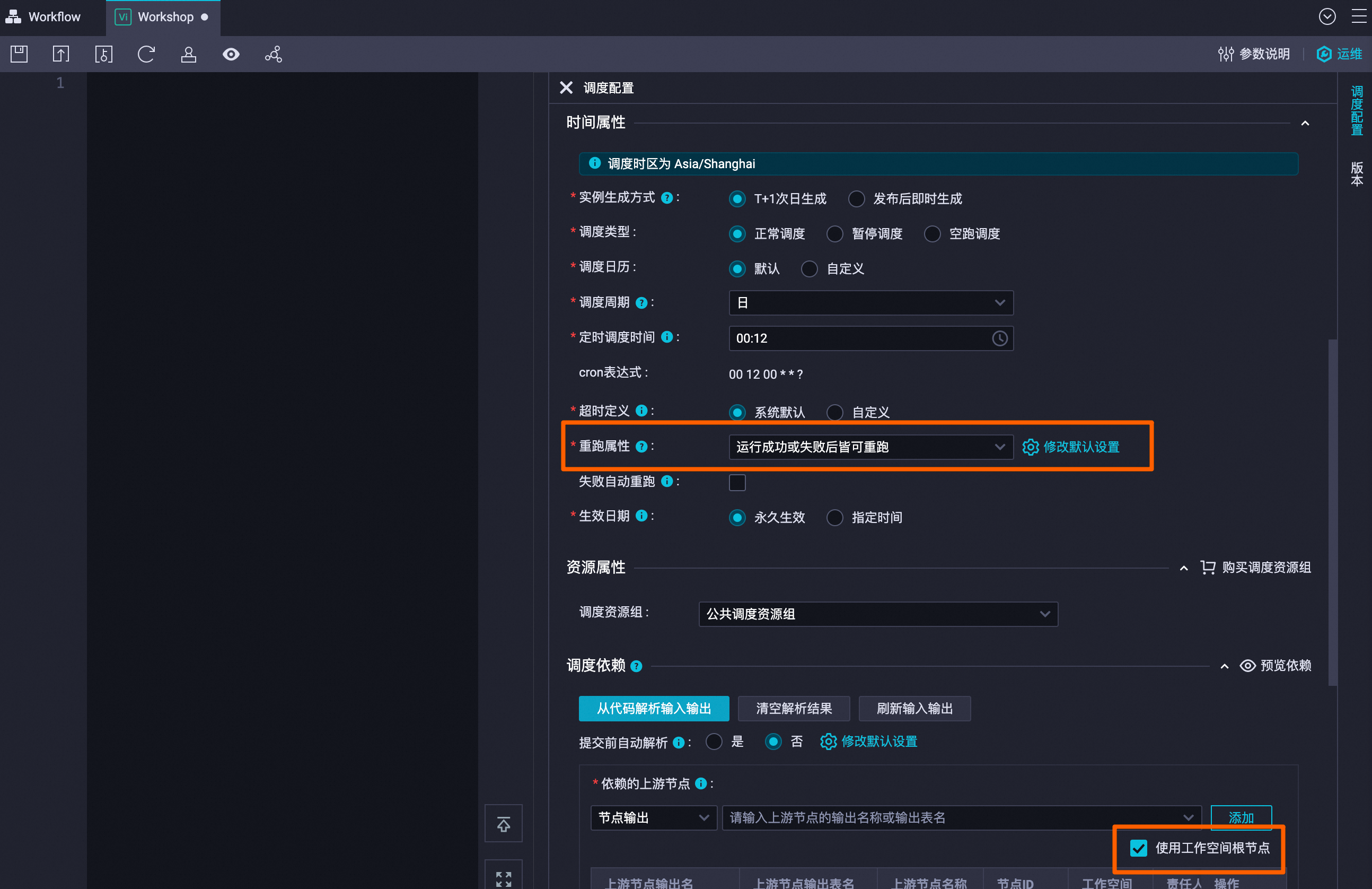

雙擊虛擬節點(Workshop),配置如下周期調度參數后,單擊頂部的保存(

)。說明

)。說明其他參數保持默認即可。

切換至Workflow業務流程頁簽,單擊頂部的運行,確認運行業務流程,參數bizdate填寫為前一天(例如今天為20240731,則此處填寫為20240730),單擊確定測試所有流程是否均能成功運行。

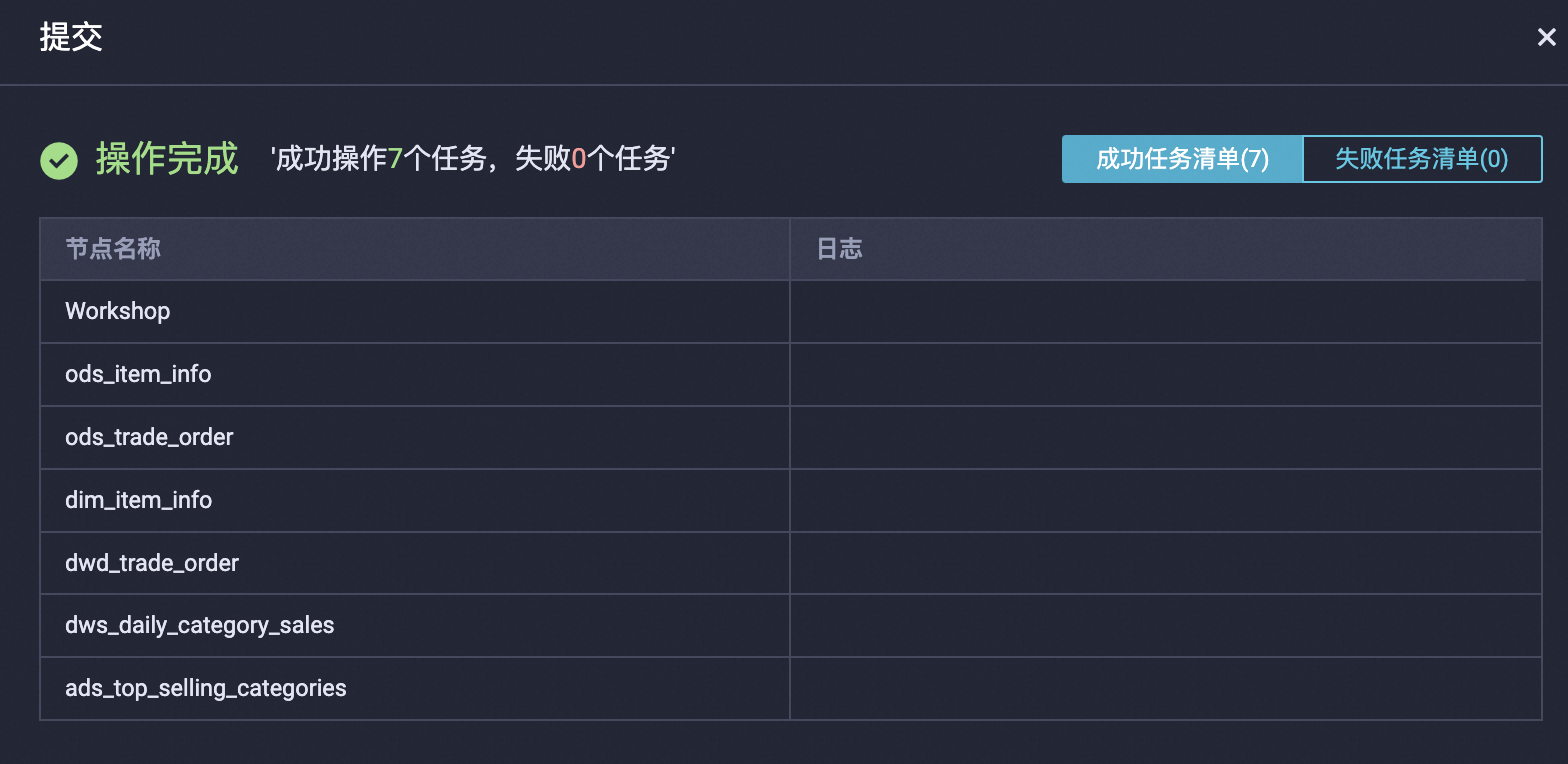

所有節點均能成功運行后,點擊頂部的提交,將流程中所有節點提交至運維中心。

單擊左上角

圖標,在彈出頁面單擊。

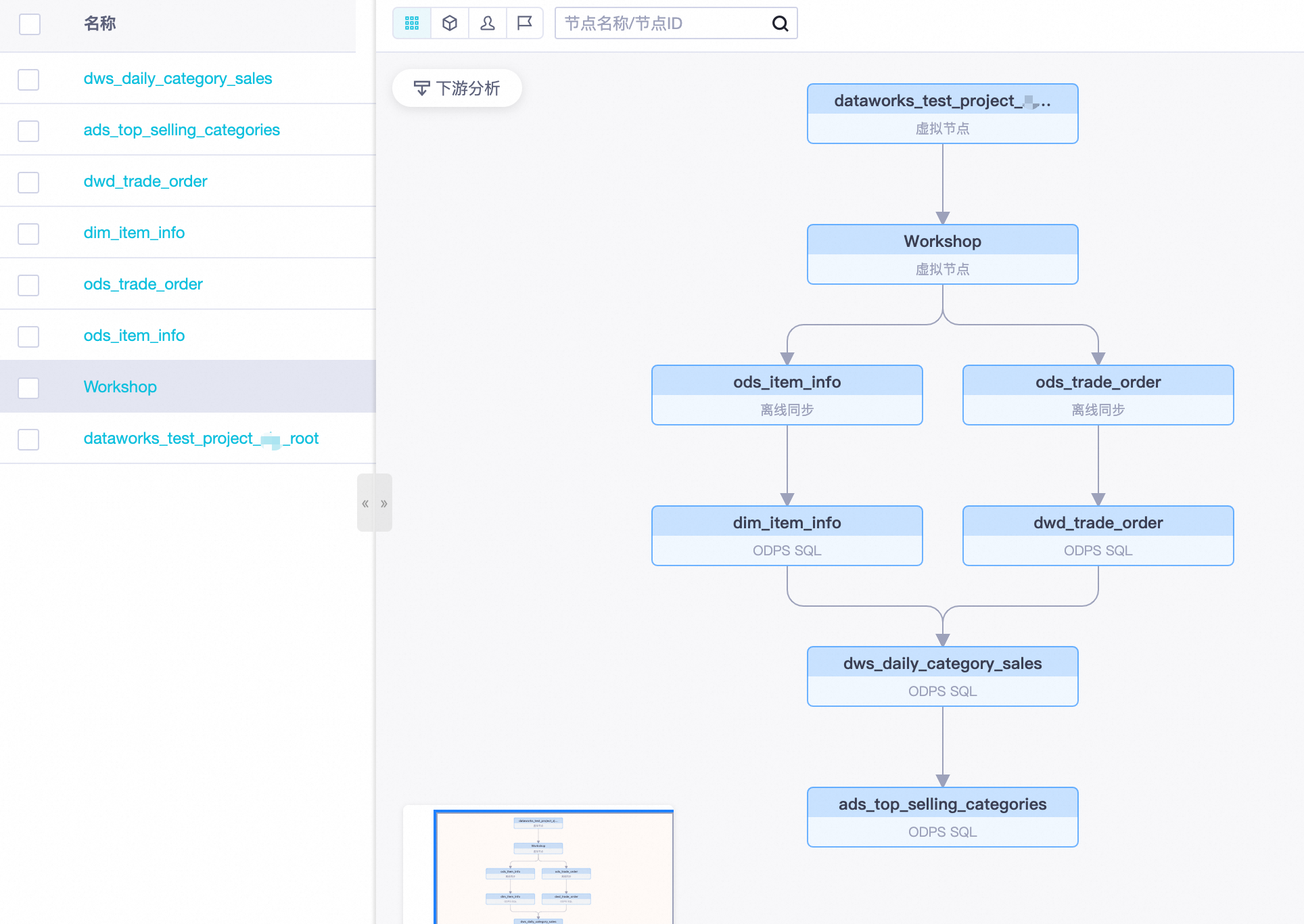

圖標,在彈出頁面單擊。在中即可看到已創建的周期任務。

說明如需展示如下圖的所有上下游依賴節點,請右鍵單擊Workshop節點,選擇。

下一步

附錄:資源釋放與清理

如果您需要釋放本次教程所創建的資源,具體操作步驟如下:

停止周期任務。

進入運維中心頁面。

登錄DataWorks控制臺,切換至目標地域后,單擊左側導航欄的,在下拉框中選擇對應工作空間后單擊進入運維中心。

在中,勾選所有之前創建的周期任務,然后在底部單擊。

刪除數據開發節點并解綁MaxCompute數據源。

進入數據開發頁面。

登錄DataWorks控制臺,切換至目標地域后,單擊左側導航欄的,在下拉框中選擇對應工作空間后單擊進入數據開發。

在中,找到已創建的離線同步節點和ODPS SQL節點,右鍵選擇刪除。

在左側導航欄,單擊數據源,找到已綁定的MaxCompute數據源,單擊解綁。在確認窗口中勾選選項后單擊解綁。

刪除數據源。

進入管理中心頁面。

登錄DataWorks控制臺,切換至目標地域后,單擊左側導航欄的,在下拉框中選擇對應工作空間后單擊進入管理中心。

在左側導航欄單擊,找到已創建的MySQL數據源和MaxCompute數據源,單擊操作列的刪除。在刪除窗口中單擊繼續。

刪除MaxCompute項目。

登錄MaxCompute管理控制臺,找到已創建的MaxCompute項目,單擊操作列的刪除,在確認窗口中勾選選項后單擊確定。

刪除公網NAT網關并釋放彈性公網IP。

登錄專有網絡-公網NAT網關控制臺,在頂部菜單欄切換至華東2(上海)地域。

找到已創建的公網NAT網關,單擊操作列的,在確認窗口中,勾選強制刪除,然后單擊確定。

在左側導航欄單擊,找到已創建的彈性公網IP,單擊操作列中,在確認窗口中單擊確定。

> 刪除

> 刪除