本文聊天機器人為例,介紹如何使用Alibaba Cloud AI Containers(簡稱AC2)提供的AI容器鏡像在Intel CPU上部署通義千問Qwen-7B-Chat。

背景信息

通義千問-7B(Qwen-7B)是阿里云研發的通義千問大模型系列的70億參數規模模型。Qwen-7B是基于Transformer的大語言模型,在超大規模的預訓練數據上進行訓練得到。預訓練數據類型多樣,覆蓋廣泛,包括大量網絡文本、專業書籍、代碼等。同時,在Qwen-7B 的基礎上,使用對齊機制打造了基于大語言模型的AI助手Qwen-7B-Chat。

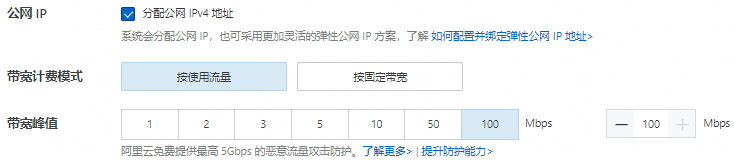

步驟一:創建ECS實例

步驟二:創建Docker運行環境

安裝Docker。

在Alibaba Cloud Linux 3上安裝Docker可以參考安裝Docker并使用(Linux)。

運行以下命令,確保Docker守護進程已經啟用。

sudo systemctl status docker運行以下命令,創建并運行PyTorch AI容器。

AC2提供了豐富的AI場景下的容器鏡像,其中就包括針對Intel優化的PyTorch鏡像,可以使用該鏡像快速創建一個PyTorch運行環境。

sudo docker pull ac2-registry.cn-hangzhou.cr.aliyuncs.com/ac2/pytorch:2.0.1-3.2304 sudo docker run -itd --name pytorch --net host -v $HOME/workspace:/workspace \ ac2-registry.cn-hangzhou.cr.aliyuncs.com/ac2/pytorch:2.0.1-3.2304

步驟三:手動部署Qwen-7B-Chat

運行以下命令,進入容器環境。

sudo docker exec -it -w /workspace pytorch /bin/bash后續命令需在容器環境中執行,如意外退出,請使用以上命令重新進入容器環境。您可以運行

cat /proc/1/cgroup | grep docker命令查看當前環境是否為容器,如有回顯信息則為容器環境。運行以下命令,安裝配置軟件。

yum install -y tmux git git-lfs wget運行以下命令,啟用Git LFS。

下載預訓練模型需要Git LFS的支持。

git lfs install下載源碼與模型。

運行以下命令,創建一個tmux session。

tmux說明下載預訓練模型耗時較長,且成功率受網絡情況影響較大,建議在tmux session中下載,以免ECS斷開連接導致下載模型中斷。

運行以下命令,下載Qwen-7B項目源碼,以及預訓練模型。

git clone https://github.com/QwenLM/Qwen.git git clone https://www.modelscope.cn/qwen/Qwen-7B-Chat.git qwen-7b-chat --depth=1運行以下命令,查看當前目錄。

ls -l

運行以下命令,部署運行環境。

AC2容器中,集成了眾多的Python AI依賴組件,可以直接使用

yum或dnf安裝Python運行依賴。yum install -y python3-{transformers{,-stream-generator},tiktoken,accelerate} python-einops運行AI對話。

運行以下命令,修改模型加載參數。

在項目源碼中提供了終端示例腳本,可以運行Qwen-7B-Chat模型實現本地聊天機器人。在運行腳本之前,需要修改模型加載參數,使用BF16精度加載,以利用CPU的AVX-512指令集進行加速。

cd /workspace/Qwen grep "torch.bfloat16" cli_demo.py 2>&1 >/dev/null || sed -i "57i\torch_dtype=torch.bfloat16," cli_demo.py運行以下命令,啟動聊天機器人。

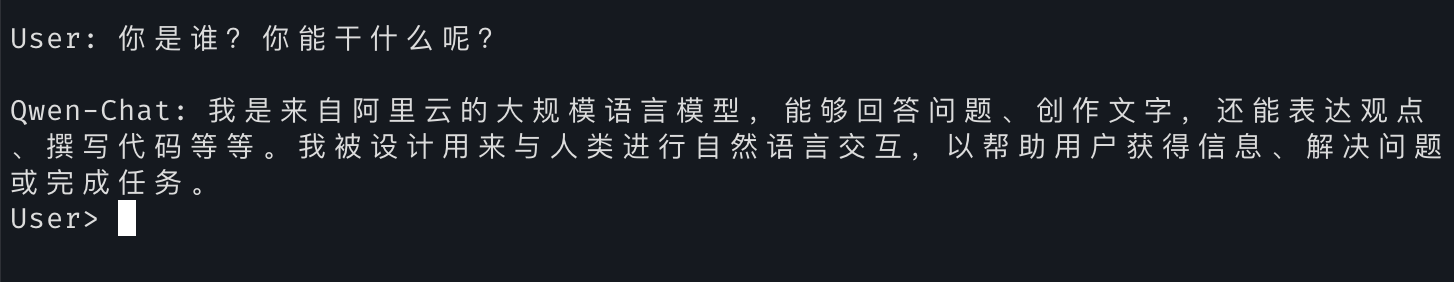

cd /workspace/Qwen python3 cli_demo.py -c ../qwen-7b-chat --cpu-only部署完成后可以通過在

User>提示符處輸入對話內容,就可以與Qwen-7B-Chat大模型進行實時對話。 說明

說明您可以運行

:exit命令退出聊天機器人。